Современные большие языковые модели (Large Language Models, LLMs) демонстрируют выдающиеся способности в обработке естественного языка, решении сложных задач и даже прохождении профессиональных экзаменов. Однако остается открытым вопрос: действительно ли они понимают язык, или их успехи основаны лишь на статистической обработке текстов? Исследователи разработали Тест двух слов (Two Word Test, TWT), который позволяет объективно оценить семантические способности языковых моделей. Этот тест выявил важные ограничения LLMs, показывая, что даже самые передовые ИИ могут ошибаться в простых задачах, с которыми легко справляется человек.

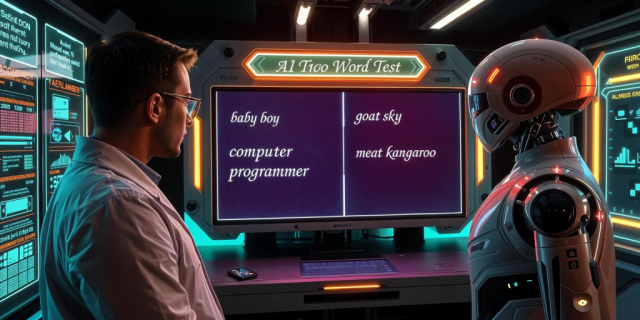

Цель исследования и методологияОсновная цель исследования заключалась в проверке способности языковых моделей различать осмысленные и бессмысленные сочетания слов. Для этого был разработан Тест двух слов (TWT), в котором использовались 1768 пар существительных. Эти пары были разделены на две категории:

- Осмысленные сочетания, например, baby boy (мальчик-младенец) или computer programmer (программист);

- Бессмысленные сочетания, такие как goat sky (козел небо) или meat kangaroo (мясо кенгуру).

Для проверки теста привлекли 150 человек, которые оценивали осмысленность фраз по шкале от 0 до 4. Затем тот же тест был проведен на четырех современных языковых моделях: GPT-4-turbo, GPT-3.5-turbo, Claude-3-Opus и Gemini-1-Pro-001.

Моделям предлагалось оценить осмысленность фраз в двух вариантах:

1. Шкала от 0 до 4, где 0 означало «бессмысленно», а 4 — «полностью осмысленно».

2. Бинарный тест, в котором необходимо было определить, является ли сочетание осмысленным («makes sense») или нет («nonsense»).

Результаты тестирования1. Ошибки в оценке осмысленности

Оказалось, что языковые модели часто приписывали смысл бессмысленным фразам. Особенно это проявлялось в моделях GPT-3.5 и Gemini-1-Pro-001, которые оценивали бессмысленные сочетания так, будто они имели смысл. Claude-3-Opus показал лучший результат, но все же не достиг уровня человеческой точности.

2. Чувствительность к порядку слов

Люди легко понимают разницу между такими сочетаниями, как beach ball (пляжный мяч) и ball beach (мяч пляж). Однако языковые модели часто не различали подобные перестановки и считали их одинаково осмысленными.

3. Зависимость от частотности слов

Один из ключевых выводов исследования — языковые модели полагаются не столько на реальную семантику, сколько на частотность фраз в текстах. Если сочетание встречается в текстах, ИИ склонен считать его осмысленным, даже если оно на самом деле бессмысленно.

4. Неспособность к семантической критике

Человеческий мозг обладает встроенной способностью подвергать слова критическому осмыслению, понимая, какие сочетания имеют смысл, а какие — нет. У языковых моделей такой способности нет: они «пытаются» придать смысл даже очевидно бессмысленным сочетаниям.

Что означают эти результаты?Это исследование ставит под сомнение утверждения о том, что LLMs приближаются к человеческому пониманию языка. Да, они могут решать сложные задачи, но их ошибки в элементарных тестах, таких как TWT, говорят о принципиальных ограничениях.

Основные выводы:

- Текущие языковые модели не обладают настоящим пониманием языка — они просто находят вероятностные связи между словами.

- Даже самые продвинутые LLMs не могут уверенно отличать осмысленные сочетания слов от бессмысленных.

- Для реального улучшения ИИ необходимо разрабатывать новые методы, которые помогут моделям лучше оценивать смысл фраз, а не просто полагаться на частотность слов.

Практическое значение исследованияВыводы исследования важны для многих сфер применения искусственного интеллекта:

- Автоматизированный перевод. Если ИИ не понимает смысл фраз, он может допускать серьезные ошибки при переводе.

- Генерация контента. Языковые модели могут создавать правдоподобные, но бессмысленные тексты.

- Поисковые системы. Если поисковый алгоритм не различает осмысленные и бессмысленные запросы, это может ухудшить релевантность результатов.

Исследователи рекомендуют осторожно относиться к утверждениям, что языковые модели достигли уровня человеческого понимания. Важно продолжать развивать тесты, подобные TWT, чтобы выявлять слабые места ИИ и совершенствовать их архитектуру.

Несмотря на впечатляющие успехи, LLMs все еще далеки от настоящего понимания языка. Тест двух слов (TWT) показал, что даже самые передовые модели делают ошибки в задачах, которые для человека кажутся очевидными. Это еще раз доказывает, что ИИ — это мощный инструмент, но не полноценная замена человеческого интеллекта.

Будущие исследования могут помочь разработать новые способы обучения языковых моделей, чтобы они лучше распознавали семантическую осмысленность и не допускали таких ошибок. Однако пока что пользователям стоит помнить о границах возможностей искусственного интеллекта и не полагаться на него без критического осмысления его ответов.

#

ИИ #

AI #

ТестДвухСлов #

AIvsHuman